SuperCLUE-Auto

SuperCLUE-Math6: 新一代中文原生多轮多步数学推理数据集

在人工智能领域,我们正见证着大语言模型如ChatGPT和GPT-4的蓬勃发展,它们是我们走向通用人工智能梦想的关键一步。中文大模型的推出,更是开启了人

工智能在各行各业的全新应用时代;

像GSM8K数学推理任务,由于可以考察多步逻辑推理推能力、应用数学和实现知识的能力、需要自然语言理解和解决方案、

具备精确的评估标准的任务,受到了广泛的使用。

然而,在这一进程中,缺乏能够测试中文大模型在数学推理上能力的原生数据集,导致中文模型的数学逻辑能力评估,

一直依赖于英文测试集。

为了缓解这一问题,我们推出了SuperCLUE-Math6数据集。这是一个GSM8K的中文升级版,专门设计来测试中文大模型在数学推理方面的核心能力。 SuperCLUE-Math6不仅延续了GSM8K的高质量和多样性,更在难度和应用广度上进行了适当的扩充。它的推出,旨在解决中文模型评估中的关键问题,并提供一个全面的测试平台。

SuperCLUE-Math6具有四大特点:

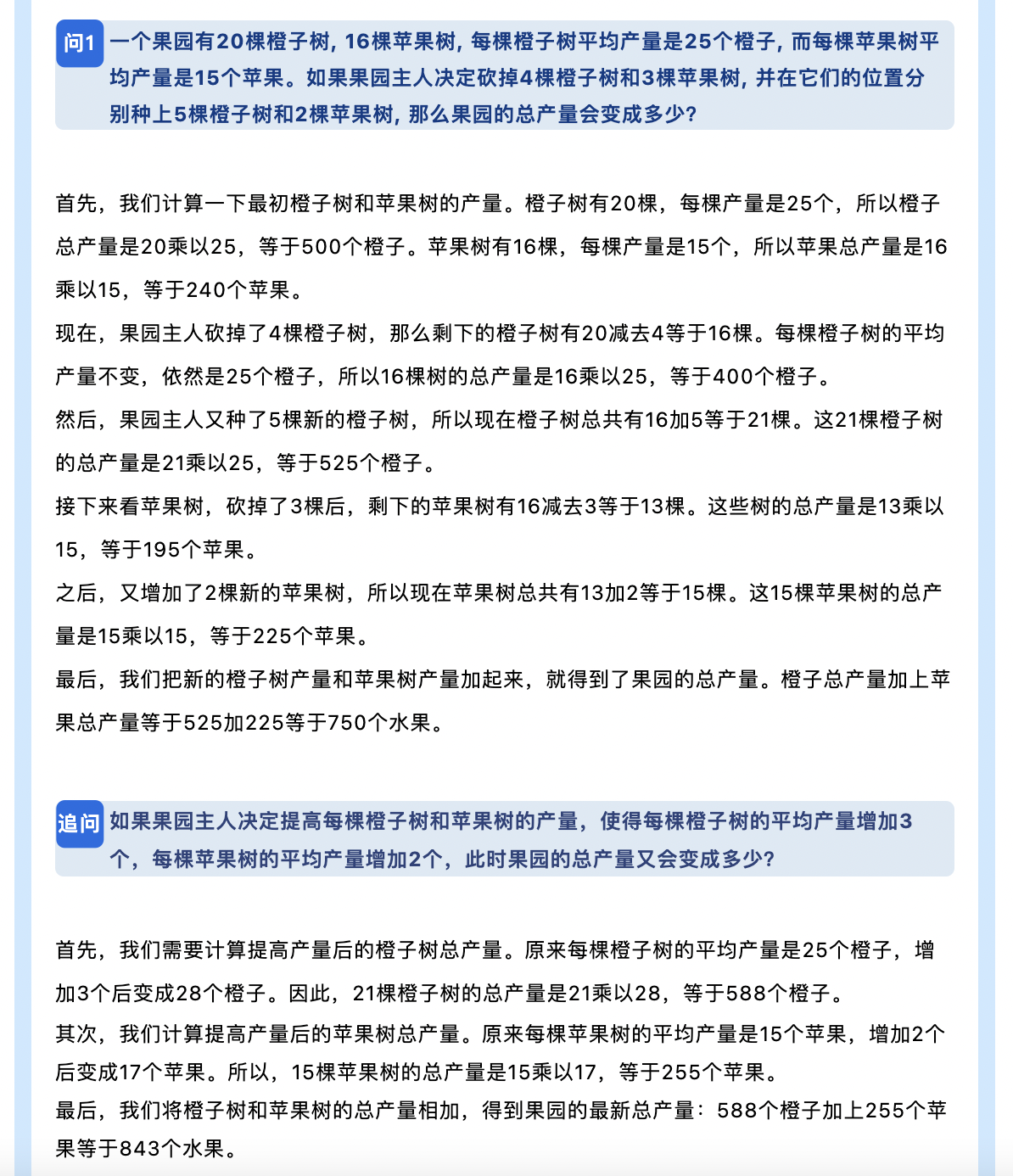

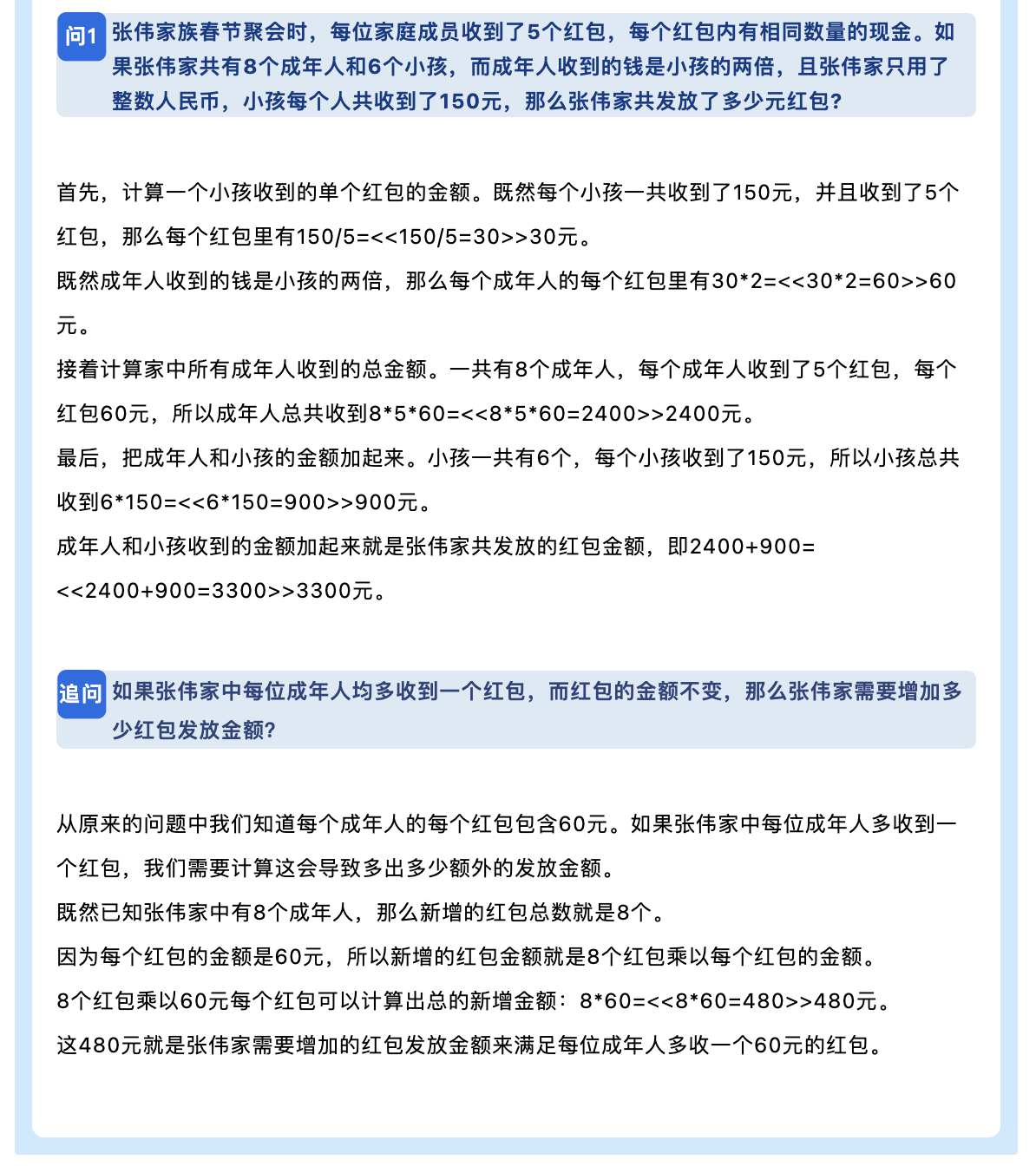

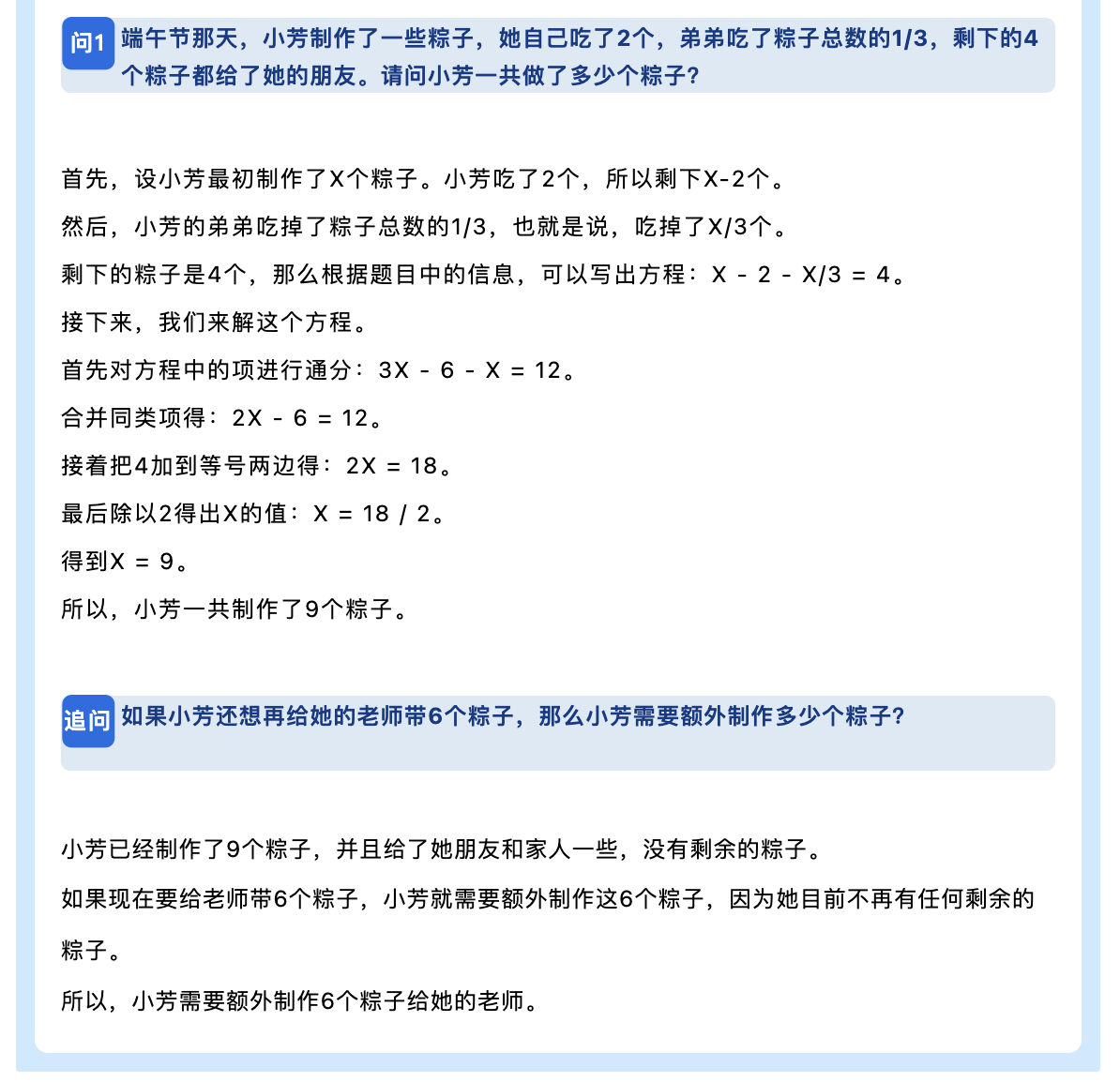

1. 中文原生场景的数学推理:每个问题均以中文原生环境呈现,配备详细的自然语言解题方案,强化了模型在本土语言环境下的适用性和实际应用价值。

2. 多轮交互下的推理能力考察:适应真实交流,通过问题及其追问,考察模型在连续对话环境中的逻辑推理与问题解决能力。

3. 推理能力等级自动评定:独创的评估系统能自动给出大模型处理数学问题的推理能力等级,为模型智力水平提供量化指标。

4. 内容的丰富性和具体化:包含数百个场景,确保模型在多种情境下均能得到有效评估,提高了数据集的应用范围和实用性。

SuperCLUE-Math的推出不仅填补了中文数学推理数据集的空缺,而且对于提升中文大模型在复杂逻辑和数学问题解决能力上的表现具有重要价值。

期待SuperCLUE-Math能激励更多的创新,推动人工智能技术在各行各业的广泛应用,从而为社会带来更深远的影响。

| 序号 | 对比项目 | SC-Math6 | GSM8K |

|---|---|---|---|

| 1 | 数学逻辑推理 | YES | YES |

| 2 | 自然语言解决方案 | YES | YES |

| 3 | 小学数学知识 | YES | YES |

| 4 | 多步推理 | YES | YES |

| 5 | 中文原生场景 | YES | NO |

| 6 | 多轮深入推理 | YES | NO |

| 7 | 题目推理步骤数 | YES | NO |

| 8 | 可解析性的模型推理等级 | YES | NO |

| 9 | 测试题数量 | 2024题 (1012对) |

1300题 |

| 推理步数 | 题目占比(%) |

|---|---|

| 1 | 15-20 |

| 2 | 15-20 |

| 3 | 45-50 |

| 4 | 5-10 |

| 5 | 5-10 |

我们介绍了一种创新的方案来评估大模型的推理能力。它通过结合模型在不同推理步骤的表现和总体准确率,以科学且公正的方式进行评估。 其特点在于简明易懂,通过合理的阈值设置,确保了性能相近的模型被归入同一等级,方便了对新模型的快速评级,而无需重新评估现有模型。 这提供了一个透明、易于理解的框架,帮助公众衡量和比较大模型的推理能力和智力水平。

为了设计一个科学且综合的方案来计算模型的推理等级,我们可以采用以下步骤:

采取完全匹配的方式,计算准确率。 其中,答案只能是非负整数。

使用的Prompt: <这里问题的内容>

注意:回答格式如下:“解题过程+'\n\n'+最终答案:【XXX】”。XXX,必须为非负整数,如35;解题过程中如涉及小数可保留两位数,最终结果如有小数四舍五入为非负整数。

| 模型名称 | 机构 | 使用方式 |

|---|---|---|

| GPT_4_1106_Preview | OpenAI | API |

| GPT_4 | OpenAI | API |

| 文心一言4.0 | 百度 | API |

| GPT_3.5_Turbo | OpenAI | API |

| ChatGLM_Turbo | 智谱AI | API |

| Qwen_14B_Chat | 阿里云 | API |

| Baichuan2_13B_Chat | 百川智能 | 模型 |

| ChatGLM3_6B | 智谱AI | 模型 |

| 讯飞星火_V3.0 | 科大讯飞 | API |

| 文心一言3.5 | 百度 | 模型 |

| Chinese_Alpaca2_13B | Yiming Cui | 模型 |

| 模型名称 | 推理 等级 |

综合 得分 |

推理步数 加权得分 |

准确率 综合得分 |

|---|---|---|---|---|

| GPT_4_1106_Preview | 5级 | 87.76 | 88.60 | 86.92 |

| GPT_4 | 5级 | 83.86 | 83.60 | 84.12 |

| 文心一言4.0 | 5级 | 79.64 | 80.73 | 78.55 |

| GPT_35_Turbo | 4级 | 53.75 | 54.87 | 52.64 |

| ChatGLM_Turbo | 4级 | 52.55 | 53.60 | 51.49 |

| Qwen_14B_Chat | 4级 | 49.05 | 49.73 | 48.37 |

| 讯飞星火_V3.0 | 3级 | 37.39 | 40.87 | 33.91 |

| Baichuan2_13B_Chat | 3级 | 36.76 | 38.40 | 35.12 |

| ChatGLM3_6B | 3级 | 33.03 | 34.13 | 31.92 |

| 文心一言3.5 | 2级 | 21.01 | 22.20 | 19.82 |

| Chinese_Alpaca2_13B | 2级 | 18.09 | 18.67 | 17.51 |

| 模型名称 | 全面 准确率 |

平均 准确率 |

第一轮 准确率 |

第二轮 准确率 |

两轮 差异 |

|---|---|---|---|---|---|

| GPT_4_1106_Preview | 83.68 | 90.16 | 94.22 | 86.10 | -8.12 |

| GPT_4 | 80.50 | 87.73 | 91.70 | 83.77 | -7.93 |

| 文心一言4.0 | 73.32 | 83.77 | 89.74 | 77.80 | -11.94 |

| GPT_3.5_Turbo | 43.94 | 61.33 | 72.48 | 50.19 | -22.29 |

| ChatGLM_Turbo | 42.44 | 60.54 | 71.92 | 49.16 | -22.76 |

| Qwen_14B_Chat | 38.54 | 58.19 | 72.31 | 44.06 | -28.25 |

| Baichuan2_13B_Chat | 25.09 | 45.15 | 59.24 | 31.06 | -28.18 |

| ChatGLM3_6B | 21.23 | 42.60 | 56.72 | 28.44 | -28.28 |

| 讯飞星火_V3.0 | 20.52 | 47.29 | 69.12 | 25.47 | -43.65 |

| Chinese_Alpaca2_13B | 10.23 | 24.79 | 33.21 | 16.32 | -16.89 |

| 文心一言3.5 | 9.51 | 30.13 | 43.00 | 17.26 | -25.74 |

| 模型名称 | 指令遵循率 (答案) |

回答 长度 |

|---|---|---|

| GPT_4_1106_Preview | 99.44 | 173.48 |

| GPT_4 | 99.21 | 126.75 |

| 文心一言4.0 | 68.04 | 143.78 |

| GPT_3.5_Turbo | 54.64 | 82.11 |

| ChatGLM_Turbo | 60.15 | 91.84 |

| Qwen_14B_Chat | 90.67 | 71.1 |

| Baichuan2_13B_Chat | 1.54 | 70.00 |

| ChatGLM3_6B | 20.91 | 56.29 |

| 讯飞星火_V3.0 | 53.66 | 61.03 |

| Chinese_Alpaca2_13B | 18.15 | 46.50 |

| 文心一言3.5 | 64.68 | 43.14 |

| 模型名称 | 步数1 | 步数2 | 步数3 | 步数4 | 步数5 |

|---|---|---|---|---|---|

| GPT_4_1106_Preview | 0.92 | 0.89 | 0.91 | 0.89 | 0.86 |

| GPT_4 | 0.92 | 0.91 | 0.89 | 0.82 | 0.77 |

| 文心一言4.0 | 0.87 | 0.85 | 0.85 | 0.81 | 0.75 |

| GPT_3.5_Turbo | 0.73 | 0.65 | 0.61 | 0.48 | 0.49 |

| ChatGLM_Turbo | 0.70 | 0.65 | 0.60 | 0.51 | 0.44 |

| Qwen_14B_Chat | 0.72 | 0.58 | 0.60 | 0.47 | 0.38 |

| Baichuan2_13B_Chat | 0.56 | 0.48 | 0.44 | 0.38 | 0.28 |

| ChatGLM3_6B | 0.58 | 0.49 | 0.41 | 0.27 | 0.25 |

| 讯飞星火_V3.0 | 0.62 | 0.48 | 0.47 | 0.31 | 0.38 |

| 文心一言3.5 | 0.49 | 0.29 | 0.29 | 0.16 | 0.15 |

| Chinese_Alpaca2_13B | 0.40 | 0.29 | 0.22 | 0.14 | 0.12 |

| 模型名称 | SC-Math6 全面准确率 |

GSM8K | 成绩来源 |

|---|---|---|---|

| GPT_4_1106_Preview | 83.68 | 未报告 | -- |

| GPT_4 | 80.50 | 92.0 (5-shot CoT) |

GPT-4 report |

| 文心一言4.0 | 73.32 | 未报告 | -- |

| GPT_3.5_Turbo | 43.94 | 57.1 (5-shot) |

GPT-4 report |

| ChatGLM_Turbo | 42.44 | 未报告 | -- |

| Qwen_14B_Chat | 38.54 | 50.3 (0-shot) |

Modelscope 项目 |

| Baichuan2_13B_Chat | 25.09 | 52.77 (base) |

Baichuan2 report |

| ChatGLM3_6B | 21.23 | 72.3 (0-shot CoT) |

ChatGLM3-6B Github |

| 讯飞星火_V3.0 | 20.52 | 未报告 | - |

| Chinese_Alpaca2_13B | 10.23 | 未报告 | - |

| 文心一言3.5 | 9.51 | 未报告 | - |

通过我们获得的推理等级数据,我们可以得出以下三个关键结论:

顶级模型(如GPT_4_1106_Preview、GPT_4 和文心一言4.0 )在推理任务中展现了卓越的性能,特别是在处理高难度的多步推理任务时。

它们在推理能力和准确性方面均达到了较高的标准,证明了当前大模型的先进水平。

通过对不同模型的综合评估,我们可以看到性能上的明显分层。高等级模型在复杂任务上的表现远远超过低等级模型,这反映了在大模型领域内技术和能力的多样性和分层。

不同等级的模型提供了根据具体应用场景和需求选择合适模型的依据。例如,对于需要高精度和复杂推理能力的任务,更适合选择等级较高的模型;

而对于一些基础应用,则可以考虑使用等级较低但仍具有效率和准确性的模型。

通过分析准确率和指令遵循率得分情况,我们还可以看到:

在所有模型中,第二轮准确率普遍低于第一轮准确率,这表明随着任务复杂度的增加(从第一轮到第二轮),模型的性能出现了下降。这种趋势在所有模型中普遍存在, 表明在设计和优化模型时,需要特别关注其在持续任务中的稳定性和适应性。

比如,GPT_4_1106_Preview的第一轮准确率为94.22%,而第二轮准确率为86.10%,准确率下降了8.12%。同样地,ERNIE_35_Turbo_v2的第一轮准确率为43.00%,第二轮准确率为17.26%,下降了25.74%。

GPT_4_1106_Preview和GPT_4在各项指标中均表现优异,尤其在全面准确率和平均准确率方面。这反映了GPT系列模型在处理复杂任务时的高效性和可靠性, 同时也表明了其在语言理解和生成方面的先进性。 GPT_4_1106_Preview在全面准确率上达到了83.68%,平均准确率为90.16%,而GPT_4的全面准确率为80.50%,平均准确率为87.73%,均高于其他模型。

高指令遵循率模型(如GPT_4_1106_Preview和GPT_4)通常也展现了较高的准确率,而低指令遵循率模型(如Baichuan2_13B_Chat)则准确率较低。 这表明指令遵循率可能是衡量模型整体性能的一个重要指标,尤其在评估模型对任务要求的理解和执行能力时。 GPT_4_1106_Preview的指令遵循率为99.44%,全面准确率为83.68%,而Chinese_Alpaca2_13B的指令遵循率仅为18.15%,全面准确率也较低,仅为10.23%。

在某些模型(如GPT_4_1106_Preview)中,较高的准确率伴随着较长的平均答案长度,这可能暗示这些模型在生成详尽回答时更为精确。 然而,这一趋势并不在所有模型中一致出现,表明答案长度与准确率之间的关系可能受多种因素影响,包括模型的设计和训练数据。 GPT_4_1106_Preview的平均答案长度为173.48,准确率较高,而ChatGLM3_6B的平均答案长度为56.29,准确率相对较低。这暗示在某些情况下,答案长度可能与准确率相关。

观察各模型之间的性能差异,可能反映了它们在架构、训练数据集、优化策略等方面的不同。例如,GPT系列模型可能因为更大的模型规模、更广泛的训练数据或更高级的优化技术而表现更佳。 对这些差异的深入研究有助于理解和改进现有模型的性能。

微信群:

联系人:

联系人:

SuperCLUE中文大模型排行榜(2023年7月)

| 排名 | 模型 | 机构 | 总分 | 基础能力 | 中文特性 | 学术专业 | 许可证 |

|---|---|---|---|---|---|---|---|

| 🧝 | 人类 | CLUE | 83.66 | 85.03 | 82.29 | - | - |

| - | GPT-4 | OpenAI | 70.89 | 70.04 | 72.67 | 69.96 | 专有服务 |

| 🏅 | 文心一言(v2.2.0) | 百度 | 62.00 | 61.11 | 71.38 | 53.50 | 专有服务 |

| - | Claude-2 | Authropic | 60.94 | 62.01 | 61.18 | 59.63 | 专有服务 |

| - | gpt-3.5-turbo | OpenAI | 59.79 | 64.40 | 63.19 | 51.78 | 专有服务 |

| 🥈 | ChatGLM-130B | 清华大学&智谱AI | 59.35 | 53.78 | 71.39 | 52.89 | 专有服务 |

| 🥉 | 讯飞星火(v1.5) | 科大讯飞 | 58.02 | 63.32 | 65.72 | 45.03 | 专有服务 |

| - | Claude-instant-v1 | Authropic | 56.31 | 58.85 | 55.91 | 54.16 | 专有服务 |

| 4 | 360智脑(4.0) | 360 | 55.04 | 56.68 | 62.54 | 45.88 | 专有服务 |

| 5 | internlm-chat-7b | 上海AI实验室与商汤 | 53.91 | 54.85 | 61.35 | 45.53 | 开源-可商用 |

| 6 | ChatGLM2-6B | 清华大学&智谱AI | 53.85 | 55.60 | 63.59 | 42.37 | 开源-可商用 |

| 7 | MiniMax-abab5.5 | MiniMax | 53.06 | 53.61 | 62.79 | 42.77 | 专有服务 |

| 8 | 通义千问(v1.0.3) | 阿里巴巴 | 51.52 | 52.84 | 61.73 | 39.98 | 专有服务 |

| 9 | Baichuan-13B-Chat | 百川智能 | 49.35 | 50.46 | 55.38 | 42.21 | 开源-可商用 |

| 10 | BELLE-LLaMA-13B-2M-enc | 链家 | 46.60 | 48.71 | 52.99 | 38.10 | 开源-非商用 |

| 11 | IDEA-姜子牙-13B-v1.1 | 深圳IDEA研究院 | 43.80 | 47.55 | 48.61 | 35.26 | 开源-非商用 |

| 12 | phoenix-7B | 香港中文大学 | 41.57 | 45.39 | 44.62 | 34.70 | 开源-可商用 |

| 13 | MOSS-16B | 复旦大学 | 35.36 | 37.01 | 38.01 | 31.07 | 开源-可商用 |

| 14 | Llama-2-13B-chat | Meta | 34.26 | 35.85 | 37.37 | 29.57 | 开源-可商用 |

| 15 | Vicuna-13B | UC伯克利 | 31.70 | 34.61 | 33.71 | 26.80 | 开源-非商用 |

| 16 | RWKV-7B-World-CHNtuned | RWKV基金会 | 27.83 | 30.71 | 28.13 | 24.66 | 开源-可商用 |

2023年7月SuperCLUE基础能力榜单

| 排名 | 模型 | 平均分 | 语义理解 | 闲聊 | 对话 | 角色扮演 | 知识与百科 | 生成与创作 | 逻辑与推理 | 代码 | 计算 | 安全 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 🧝 | 人类 | 85.03 | 90.17 | 71.53 | 77.99 | 82.19 | 97.44 | 68.79 | 90.55 | 90.45 | 94.97 | 86.22 |

| - | gpt-4 | 70.04 | 82.91 | 46.77 | 66.39 | 63.46 | 92.65 | 66.67 | 60.33 | 85.45 | 61.48 | 73.02 |

| - | gpt-3.5-turbo | 64.40 | 87.18 | 45.16 | 65.57 | 60.58 | 85.29 | 72.36 | 42.98 | 72.73 | 38.52 | 72.22 |

| 🏅️ | 讯飞星火(v1.5) | 63.32 | 78.26 | 45.90 | 59.84 | 55.88 | 73.48 | 54.92 | 54.70 | 60.00 | 76.86 | 71.54 |

| - | Claude-2 | 62.01 | 83.49 | 49.59 | 57.14 | 52.88 | 78.68 | 68.07 | 53.72 | 66.06 | 44.26 | 65.60 |

| 🥈 | 文心一言(v2.2.0) | 61.11 | 81.90 | 46.34 | 56.67 | 59.80 | 86.76 | 47.73 | 36.52 | 65.79 | 52.63 | 70.63 |

| - | Claude-instant-v1 | 58.85 | 76.52 | 50.00 | 58.20 | 55.77 | 77.04 | 61.48 | 40.00 | 66.97 | 33.61 | 67.77 |

| 🥉 | 360智脑(4.0) | 56.68 | 76.92 | 52.46 | 58.33 | 54.08 | 76.80 | 61.54 | 37.29 | 53.64 | 29.57 | 67.92 |

| 4 | ChatGLM2-6B | 55.60 | 74.36 | 44.35 | 55.74 | 56.73 | 76.47 | 51.22 | 40.50 | 41.82 | 45.08 | 66.67 |

| 5 | internlm-chat-7b | 54.85 | 80.34 | 48.39 | 55.74 | 55.77 | 77.94 | 36.59 | 37.19 | 51.82 | 34.43 | 68.25 |

| 6 | ChatGLM-130B | 53.78 | 70.94 | 45.97 | 56.56 | 61.54 | 75.74 | 55.28 | 29.75 | 45.45 | 31.15 | 63.49 |

| 7 | MiniMax-abab5.5 | 53.61 | 79.49 | 45.97 | 59.84 | 60.58 | 85.29 | 47.97 | 29.75 | 30.00 | 31.97 | 61.11 |

| 8 | 通义千问 | 52.84 | 74.77 | 45.97 | 57.98 | 53.00 | 76.69 | 38.89 | 33.06 | 46.67 | 39.67 | 60.40 |

| 9 | Baichuan-13B-Chat | 50.46 | 64.10 | 41.94 | 50.00 | 52.88 | 75.00 | 57.72 | 27.27 | 40.91 | 31.15 | 60.32 |

| 10 | BELLE-13B | 48.71 | 68.38 | 46.77 | 51.64 | 53.85 | 64.71 | 25.20 | 32.23 | 48.18 | 31.97 | 63.49 |

| 11 | IDEA-姜子牙-13B-v1.1 | 47.55 | 70.09 | 49.19 | 48.36 | 48.08 | 58.82 | 32.52 | 34.71 | 21.82 | 45.08 | 63.49 |

| 12 | Phoenix-7B | 45.39 | 66.67 | 41.94 | 43.44 | 43.27 | 55.15 | 44.72 | 31.41 | 36.36 | 33.61 | 55.56 |

| 13 | MOSS-16B | 37.01 | 54.70 | 39.52 | 40.16 | 45.19 | 35.29 | 34.96 | 24.79 | 32.73 | 27.05 | 37.30 |

| 14 | Llama-2-13B-chat | 35.85 | 52.14 | 41.94 | 40.98 | 32.69 | 33.82 | 38.21 | 28.93 | 23.64 | 27.05 | 38.10 |

| 15 | Vicuna-13B | 34.61 | 49.57 | 33.06 | 32.79 | 37.50 | 25.74 | 30.89 | 27.27 | 40.91 | 35.25 | 35.71 |

| 16 | RWKV-7B-World-CHNtuned | 30.71 | 31.62 | 20.16 | 22.13 | 26.92 | 27.21 | 23.58 | 22.31 | 36.36 | 60.66 | 36.51 |

2023年7月SuperCLUE中文特性榜单

| 排名 | 模型 | 平均分 | 字形和拼音 | 字义理解 | 句法分析 | 文学 | 诗词 | 成语 | 歇后语 | 方言 | 对联 | 古文 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 🧝 | 人类 | 82.29 | 96.01 | 83.15 | 62.71 | 91.47 | 90.79 | 92.38 | 83.78 | 69.21 | 70.00 | 83.40 |

| - | gpt-4 | 72.67 | 62.83 | 68.07 | 85.48 | 88.08 | 75.68 | 95.12 | 70.15 | 38.40 | 71.52 | 67.31 |

| 🏅️ | ChatGLM-130B | 71.39 | 48.67 | 68.07 | 75.00 | 83.44 | 84.68 | 95.94 | 67.16 | 45.60 | 70.86 | 72.12 |

| 🥈 | 文心一言(v2.2.0) | 71.38 | 59.34 | 70.34 | 73.33 | 86.58 | 82.88 | 95.12 | 60.31 | 37.60 | 71.03 | 73.79 |

| 🥉 | 讯飞星火(v1.5) | 65.72 | 47.32 | 68.38 | 77.42 | 72.03 | 69.09 | 89.43 | 59.85 | 35.77 | 71.23 | 63.46 |

| 4 | ChatGLM2-6B | 63.59 | 45.13 | 60.50 | 66.13 | 78.81 | 63.06 | 89.43 | 64.18 | 33.60 | 64.24 | 66.35 |

| - | gpt-3.5-turbo | 63.19 | 46.02 | 69.75 | 75.81 | 75.50 | 57.66 | 89.43 | 55.97 | 36.00 | 57.62 | 66.35 |

| 5 | MiniMax-abab5.5 | 62.79 | 46.90 | 57.98 | 63.71 | 75.50 | 71.17 | 86.99 | 60.45 | 41.60 | 58.94 | 62.50 |

| 6 | 360智脑(4.0) | 62.54 | 45.45 | 63.83 | 63.53 | 71.43 | 70.73 | 97.06 | 60.47 | 38.46 | 64.96 | 73.21 |

| 7 | 通义千问 | 61.73 | 41.59 | 60.87 | 60.66 | 73.65 | 67.89 | 88.24 | 51.91 | 40.68 | 68.97 | 57.89 |

| 8 | internlm-chat-7b | 61.35 | 41.59 | 58.82 | 62.10 | 76.16 | 68.47 | 86.18 | 61.94 | 32.80 | 57.62 | 65.38 |

| - | Claude-2 | 61.18 | 48.67 | 70.94 | 70.16 | 67.55 | 54.05 | 83.74 | 58.21 | 36.00 | 60.67 | 59.62 |

| - | Claude-instant-v1 | 55.91 | 43.36 | 62.16 | 72.13 | 62.91 | 50.91 | 84.87 | 47.73 | 31.20 | 56.38 | 45.19 |

| 9 | Baichuan-13B-Chat | 55.38 | 45.13 | 58.82 | 50.81 | 73.51 | 70.27 | 75.61 | 47.01 | 33.60 | 44.37 | 54.81 |

| 10 | BELLE-13B | 52.99 | 42.48 | 55.46 | 67.74 | 56.29 | 46.85 | 78.05 | 38.06 | 33.60 | 59.60 | 49.04 |

| 11 | IDEA-姜子牙-13B-v1.1 | 48.61 | 28.32 | 54.62 | 51.61 | 56.29 | 51.35 | 63.41 | 42.54 | 36.00 | 48.34 | 51.92 |

| 12 | Phoenix-7B | 44.62 | 30.09 | 51.26 | 43.55 | 51.66 | 45.95 | 65.85 | 35.07 | 32.00 | 45.03 | 44.23 |

| 13 | MOSS-16 | 38.01 | 32.74 | 43.70 | 36.29 | 40.40 | 32.43 | 60.98 | 32.09 | 31.20 | 31.13 | 40.38 |

| 14 | Llama-2-13B-chat | 37.37 | 31.86 | 40.34 | 49.19 | 37.75 | 33.33 | 43.90 | 32.09 | 32.00 | 33.77 | 40.38 |

| 15 | Vicuna-13B | 33.71 | 21.24 | 34.45 | 45.16 | 29.14 | 22.52 | 33.33 | 36.57 | 22.40 | 49.67 | 38.46 |

| 16 | RWKV-7B-World-CHNtuned | 28.13 | 25.66 | 26.05 | 25.00 | 29.80 | 26.13 | 45.53 | 17.16 | 20.00 | 36.42 | 27.88 |

2023年7月SuperCLUE开源榜单

| 排名 | 模型 | 机构 | 总分 | 基础能力 | 中文特性 | 学术专业 | 许可证 |

|---|---|---|---|---|---|---|---|

| 🧝 | 人类 | CLUE | 83.66 | 85.03 | 82.29 | - | - |

| 🏅️ | internlm-chat-7b | 上海AI实验室与商汤 | 53.91 | 54.85 | 61.35 | 45.53 | 开源-可商用 |

| 🥈 | ChatGLM2-6B | 清华大学&智谱AI | 53.85 | 55.60 | 63.59 | 42.37 | 开源-可商用 |

| 🥉 | Baichuan-13B-Chat | 百川智能 | 49.35 | 50.46 | 55.38 | 42.21 | 开源-可商用 |

| 4 | BELLE-LLaMA-13B-2M-enc | 链家 | 46.60 | 48.71 | 52.99 | 38.10 | 开源-非商用 |

| 5 | IDEA-姜子牙-13B-v1.1 | 深圳IDEA研究院 | 43.80 | 47.55 | 48.61 | 35.26 | 开源-非商用 |

| 6 | phoenix-7B | 香港中文大学 | 41.57 | 45.39 | 44.62 | 34.70 | 开源-可商用 |

| 7 | MOSS-16B | 复旦大学 | 35.36 | 37.01 | 38.01 | 31.07 | 开源-可商用 |

| 8 | Llama-2-13B-chat | Meta | 34.26 | 35.85 | 37.37 | 29.57 | 开源-可商用 |

| 9 | Vicuna-13B | UC伯克利 | 31.70 | 34.61 | 33.71 | 26.80 | 开源-非商用 |

| 10 | RWKV-7B-World-CHNtuned | RWKV基金会 | 27.83 | 30.71 | 28.13 | 24.66 | 开源-可商用 |